案例实析|GPU服务器≠堆叠GPU,高效稳定还需独特设计

简单来说,GPU服务器是利用GPU的异构计算特性,为视频编解码、深度学习、科学计算等多种场景提供快速、稳定、弹性的计算服务。然而,存在这样一种误区,将GPU服务器对等于就是GPU的堆叠。我们通过一次客户求助案例,详解GPU服务器和普通PC的区别之处。

求助案列

结果分析

很明显这是因为设备的散热能力不足,导致了关键元件(GPU)温度过高,从而导致掉卡或降频。

再加上用户所选为你自己DIY的服务器,其温度监测机制或传感器无法与品牌服务器相提并论,所以监测结果并不一定准确。

1.将目前DIY的服务器都给其他用户当小型图形工作站使用,并且只能使用单个GPU。

2.DIY服务器的GPU和CPU的散热均换成水冷。

3.务必选择专业的GPU服务器,保证工作稳定性。

术业有专攻,GPU服务器的独特之处

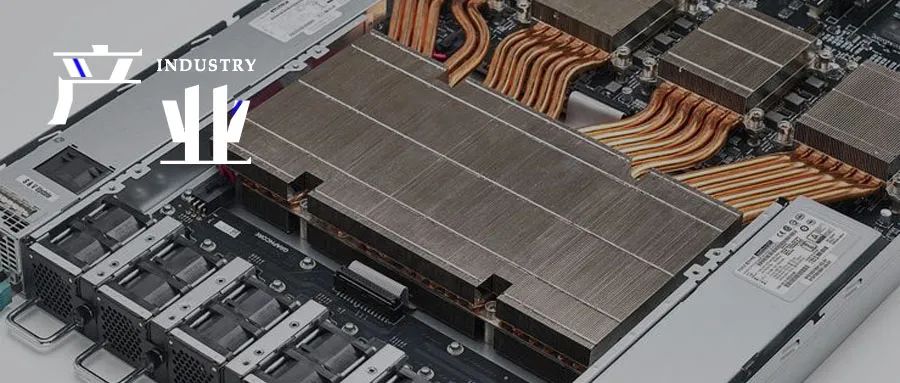

专业的GPU服务器,从供电、散热通道等多方面和通用服务器都不一样,整套散热套件的设计和零件都不是相同的。往往元件的分布需要经过精心考虑而设计,通过散热风道实验验证降温效果。

再者,GPU服务器内部的物理架构和逻辑架构是根据GPU使用环境专门设计,并通过真实环境不断检验、完善的。所以,并不是标准的X86服务器插上GPU卡就是GPU服务器了。

定制优化GPU解决方案

数据科学研究快如闪电

宽泛科技作为英特尔、英伟达等芯片及品牌厂商的坚实合作伙伴,NVIDIA潜力AI公司加速计划成员,携手专注为人工智能提供硬件解决方案及相关服务,已成为国内过万家企业、院校及研究机构的信息化解决方案供应商。

旗下Cloudhin®云轩支持Deep learning和高性能计算服务器定制,针对主要深度学习框架(如TensorFlow、Caffe 2、Theano或Torch)进行了优化和设置,为计算系统提供强大的深度学习功能。

Cloudhin®云轩GS4288-P4采用Intel C612最高速芯片组,性能稳定,把握十足。其支持两颗E5-2600 v4/v3(24核48线程),内存最大支持3TB内存。

最高可搭载8个NVIDIA图形处理器,RTX 2080/S/TI、RTX TITAN/V、TESLA T4/P100/V100,均支持按需定制。轻松应对分子动力学模拟、排序,生命科学与医疗分析、石油天然气勘探、GPU虚拟化,是复杂模型计算的理想选择。

专业勤修,锐意进取。云轩技术工程师毕业于NVIDIA深度学习研究所,丰富经验,值得信赖。更多定制方案请联系客服,我们将实时响应您的定制需求。

如果您有合作需求或宝贵建议,欢迎来信。

邮箱:hezuo@kuanfans.com

合作热线:400-610-1360转375899