选择GPU服务器的N项基本原则,加速深度学习训练不再迷茫

GPU擅长处理大规模深度学习训练以及部分典型HPC任务。经常有朋友在咨询如何配置用于深度学习或计算加速的GPU服务器,今天就与大家分享一下选择GPU服务器的基本原则。以下我们通过NVIDIA的主流产品进行实例讲解。

常见GPU服务器分类

首先介绍下常见的GPU和GPU服务器。以NVIDIA Tesla系列GPU为例,按总线接口类型可以分为NV-Link接口以及传统PCI-e总线两种。

1.NV-Link接口类型的GPU

典型代表是NVIDIA V100,采用SXM2接口,在DGX-2上有SXM3的接口。

NV-Link总线标准的GPU服务器

典型代表是NVIDIA公司设计的DGX超级计算机。DGX超级计算机不仅仅提供硬件,还有相关的软件和服务。

2.传统PCI-e总线接口的GPU

目前主流用于专业计算加速的NVIDIA Tesla GPU主要有:P4/P40(P开头指的是上一代PASCAL架构)、P100、V100以及图灵架构Tesla T4这几款。其中比较薄和只占一个槽位的P4和T4,通常用于Inference,目前也已经有成熟的模型进行推理和识别。

传统PCI-e总线的GPU服务器分为两类:

一类是OEM服务器,经过NVIDIA官方测试认证的厂商。比如我们宽泛科技不仅是NVIDIA的合作伙伴,同时已成为NVIDIA潜力AI公司加速计划成员;

另一类是非OEM的服务器,也包括很多种类。

选择GPU服务器的基本原则

选择GPU服务器时首先要考虑业务需求来选择适合的GPU型号。在HPC高性能计算中还需要根据精度来选择,比如有的高性能计算需要双精度,这时如果使用P40或者P4就不合适,只能使用V100或者P100;同时也会对显存容量有要求,比如石油或石化勘探类的计算应用对显存要求比较高;还有些对总线标准有要求,因此选择GPU型号要先看业务需求。

GPU服务器人工智能领域的应用也比较多。在教学场景中,对GPU虚拟化的要求比较高。根据课堂人数,一个老师可能需要将GPU服务器虚拟出30甚至60个虚拟GPU,因此批量Training对GPU要求比较高,通常用V100做GPU的训练。模型训练完之后需要进行推理,因此推理一般会使用P4或者T4,少部分情况也会用V100。

当GPU型号选定后,再考虑用什么样GPU的服务器。这时我们需要考虑以下几种情况:

第一、 在边缘服务器上需要根据量来选择T4或者P4等相应的服务器,同时也要考虑服务器的使用场景,比如火车站卡口、机场卡口或者公安卡口等;在中心端做Inference时可能需要V100的服务器,需要考虑吞吐量以及使用场景、数量等。

第二、 需要考虑客户本身使用人群和IT运维能力,对于BAT这类大公司来说,他们自己的运营能力比较强,这时会选择通用的PCI-e服务器;而对于一些IT运维能力不那么强的客户,他们更关注数字以及数据标注等,我们称这类人为数据科学家,选择GPU服务器的标准也会有所不同。

第三、 需要考虑配套软件和服务的价值。

第四、 要考虑整体GPU集群系统的成熟程度以及工程效率,选择有非常成熟的从底端的操作系统驱动Docker到其他部分都是优化过的服务器,这时效率就比较高。

专业深度学习解决方案加速AI研究

综上所述,选择服务器时除了分类,还要考虑性能指标,比如精度、显存类型、显存容量以及功耗等,同时也会有一些服务器是需要水冷、降噪或者对温度、移动性等等方面有特殊的要求,就需要特殊定制的服务器。

宽泛科技旗下Cloudhin®云轩支持Deep learning和高性能计算服务器定制,针对主要深度学习框架(如TensorFlow、Caffe 2、Theano或Torch)进行了优化和设置,在桌面上即可提供强大的深度学习功能。

Cloudhin®云轩GS4288-P4采用Intel C612最高速芯片组,性能稳定,可搭载两颗E5-2600 v4/v3(24核48线程),内存最大支持3TB内存。

最高可搭载8个NVIDIA图形处理器,RTX 2080/S/TI、RTX TITAN/V、TESLA T4/P100/V100,均支持按需定制。让您轻松应对分子动力学模拟、排序,生命科学与医疗分析、石油天然气勘探、GPU虚拟化服务器,是复杂模型计算的理想选择。

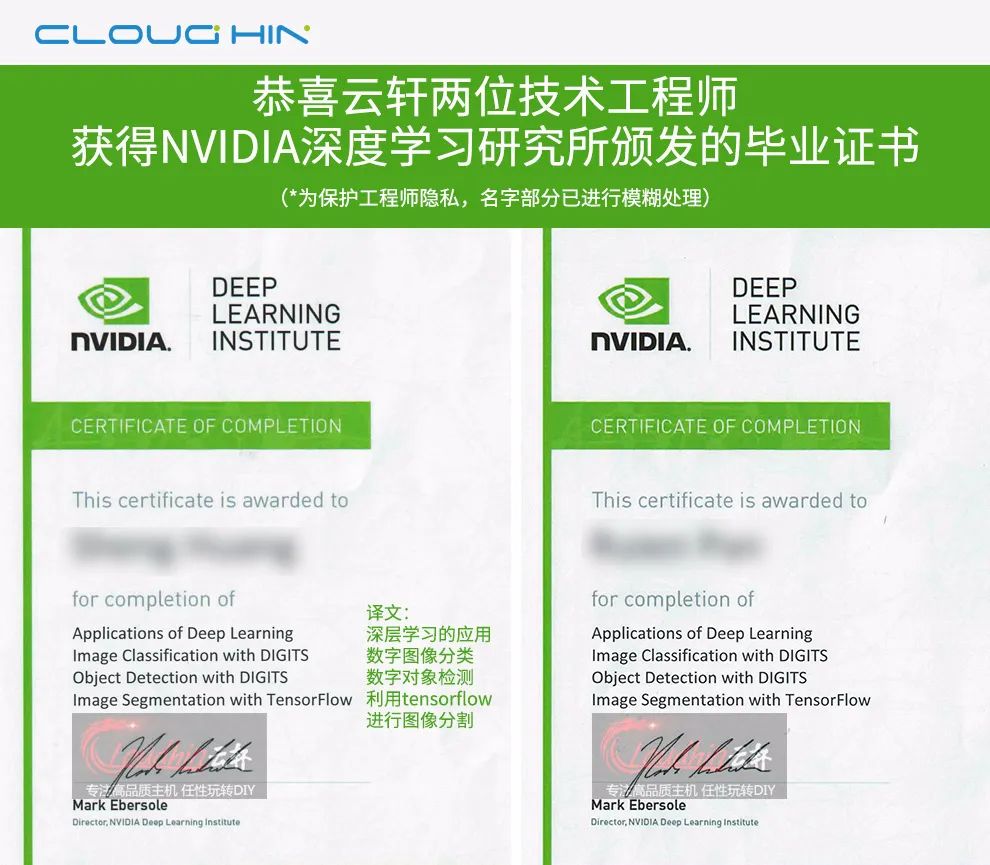

专业勤修,锐意进取。云轩技术工程师毕业于NVIDIA深度学习研究所,丰富经验,值得信赖。更多定制方案请联系客服,我们将实时响应您的定制需求。