GPU案例集|Tesla备受青睐,竟有这么多500强选择了TA!

现今,先进的AI服务愈加受到市场青睐,其中包括图像和语音识别、自然语言处理、视觉搜索和个性化推荐。与此同时,数据集不断扩大,网络也变得越来越复杂,用户期望的延迟要求也愈发严格。GPU已被证明是加速深度学习和AI工作负载的最佳解决方案,不少行业领头羊都在使用NVIDIA GPU技术加速AI推理。

在NVIDIA Clara 平台和NVIDIA GPU 技术的助力下,12 Sigma Technologies的σ-Discover/Lung 系统能够自动检测图像中小至0.01% 的肺结节,对恶性肿瘤的分析准确率超过90%,并可为放射科医生提供决策支持工具。在利用NVIDIA T4 集群进行优化后,该系统的运行速度提升18 倍。

Alibaba每天要处理83 亿个翻译请求,来支持国际商业贸易。使用神经网络机器翻译(NMT) 显著改善了翻译质量,但增加了延迟和计算成本。为补其不足并加速NMT在线服务,Ali部署了NVIDIA Tesla GPU,处理的请求数量增加3倍的同时,响应速度缩短到原来的1/3。

语音翻译帮助游客、企业、学生等群体克服了语言障碍。科大讯飞希望扩展其普通话的语音服务,支持多种口音和方言。该公司将其推理运算迁移到Tesla GPU和TensorRT,扩大了对GPU的采用。科大讯飞现可处理的并发请求数量已增加为原来的10倍,准确率提高了20%,而且TCO运营成本也已降低20%。

网络视频流量不断增加,这就要求运营企业加大监控力度,以过滤不当内容。京东在Tesla P40 GPU上使用NVIDIA DeepStream SDK 和TensorRT 来识别和过滤全高清直播视频的1000 个频道。该公司在使用推理来过滤视频内容时,吞吐量已增至20倍,而搭载Tesla的每个服务器则可同时处理20个视频。

作为一家用户规模约达10亿的中国社交媒体领先平台,微信希望提升其语音转文本服务。但在部署新的声学模型时,其CPU-only服务器却无法有效运行新版本。于是微信部署了搭载Tesla P4 GPU推理加速器的服务器,由此将语音推理吞吐量提高2.5 倍,模型内准确率提升20%,同时仍将延迟估算保持在较低水平。

定制优化GPU解决方案

实现高效精准模型推理

宽泛科技作为英特尔、英伟达等芯片及品牌厂商的坚实合作伙伴,NVIDIA潜力AI公司加速计划成员,携手专注为人工智能提供硬件解决方案及相关服务,已成为国内过万家企业、院校及研究机构的信息化解决方案供应商。

旗下Cloudhin®云轩支持Deep learning和高性能计算服务器定制,针对主要深度学习框架(如TensorFlow、Caffe 2、Theano或Torch)进行了优化和设置,在桌面上即可提供强大的深度学习功能。

NVIDIA Tesla A100接受预定中,A100由NVIDIA Ampere优化软件提供支持:包括CUDA 11;50多个CUDA-X™库的新版本;多模式对话式AI服务框架NVIDIA Jarvis;深度推荐应用框架 NVIDIA Merlin;RAPIDS™开源数据科学软件库套件;NVIDIA HPC SDK,其中内含编译器、库和软件工具,可最大程度地提高开发者的工作效率以及HPC应用的性能和可移植性。

凭借这些功能强大的软件工具,开发者们能够构建并加速HPC、基因组学、5G、数据科学、机器人学等领域的应用。

Cloudhin®云轩GS4288-P4采用Intel C612最高速芯片组,性能稳定,把握十足。其支持两颗E5-2600 v4/v3(24核48线程),内存最大支持3TB内存。

最高可搭载8个NVIDIA图形处理器,RTX 2080/S/TI、RTX TITAN/V、TESLA T4/P100/V100,均支持按需定制。它可以让你轻松应对分子动力学模拟、排序,生命科学与医疗分析、石油天然气勘探、GPU虚拟化服务器,是复杂模型计算的理想选择。

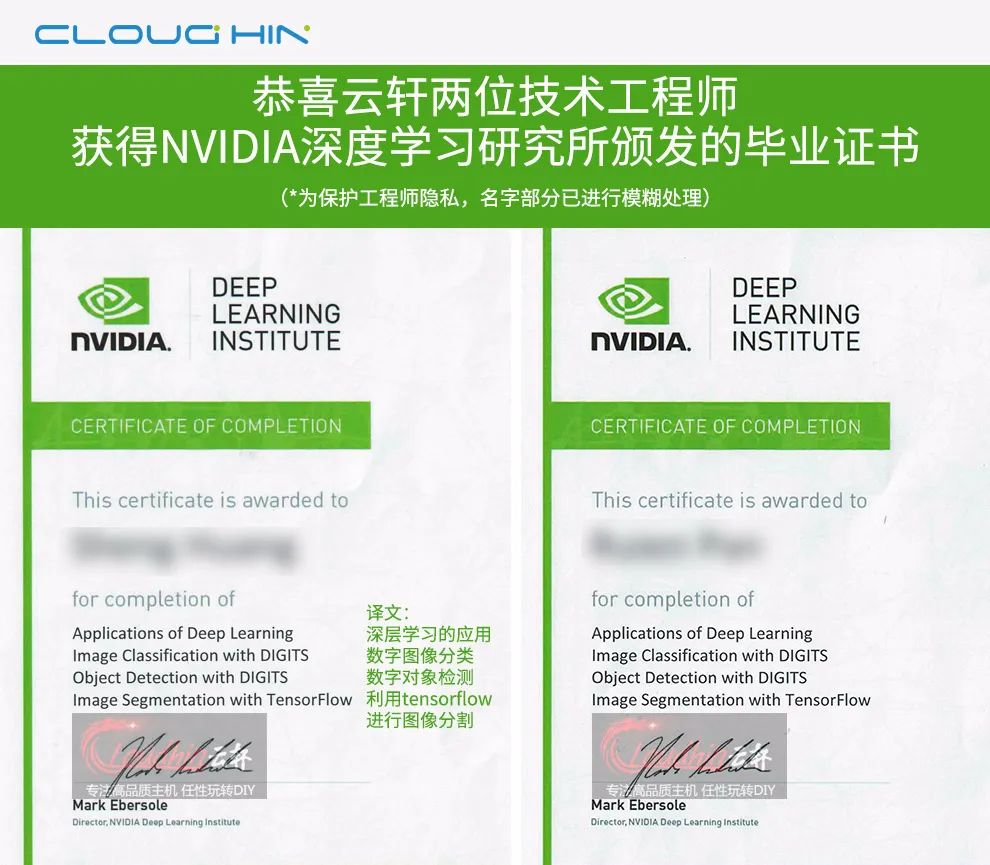

专业勤修,锐意进取。云轩技术工程师毕业于NVIDIA深度学习研究所,丰富经验,值得信赖。更多定制方案请联系客服,我们将实时响应您的定制需求。

如果您有合作需求或宝贵建议,欢迎来信。

邮箱:hezuo@kuanfans.com

合作热线:400-610-1360转375899