热烈庆祝NVIDIA发布劲爆AI核弹!

在NVIDIA GTC 2020大会上,黄仁勋终于揭开了英伟达最高机密,亲自在线发布全球最大7nm处理器、首款安培架构GPU,号称是8代GPU史上最大性能飞跃的A100!包含超过540亿个晶体管,整体性能比前一代产品直接提高了20倍,AI训练和推理能力都均有提高。

△被网友调侃准备展示“刀法”的黄仁勋

第一次,在自家的厨房里,黄仁勋开始了GTC 2020的演讲。鉴于此前英伟达的显卡造型多被吐槽为煤气灶,所以黄仁勋干脆直接在厨房中从烤箱里端出来了“预热”好的产品。从一个全新GPU架构开始,到全新GPU、全新AI系统、全新AI集群、全新边缘AI产品……每个新品的性能都非常凶残,每秒千万亿次浮点运算(PFLOPS)单位被反复提及!

实际上,英伟达的Ampere GPU其实一直是该公司的绝密之一,因此也在过去一年引发诸多猜测。从黄仁勋的首次(厨房)线上直播带货来看,以Ampere(电流之父安培)为名,英伟达的新一代 GPU 架构可谓火力全开。

「A100 是迄今为止人类制造出的最大7纳米制程芯片,」黄仁勋说道。A100 采用目前最先进的台积电7 纳米工艺,拥有540亿个晶体管,它是一块3D堆叠芯片,面积高达826mm^2,GPU的最大功率达到了400W。

这块GPU上搭载了容量40G的三星HBM2显存(比 DDR5 速度还快得多,就是很贵),第三代Tensor Core。同时它的并联效率也有了巨大提升,其采用带宽600GB/s的新版NVLink,几乎达到了10倍PCIE互联速度。

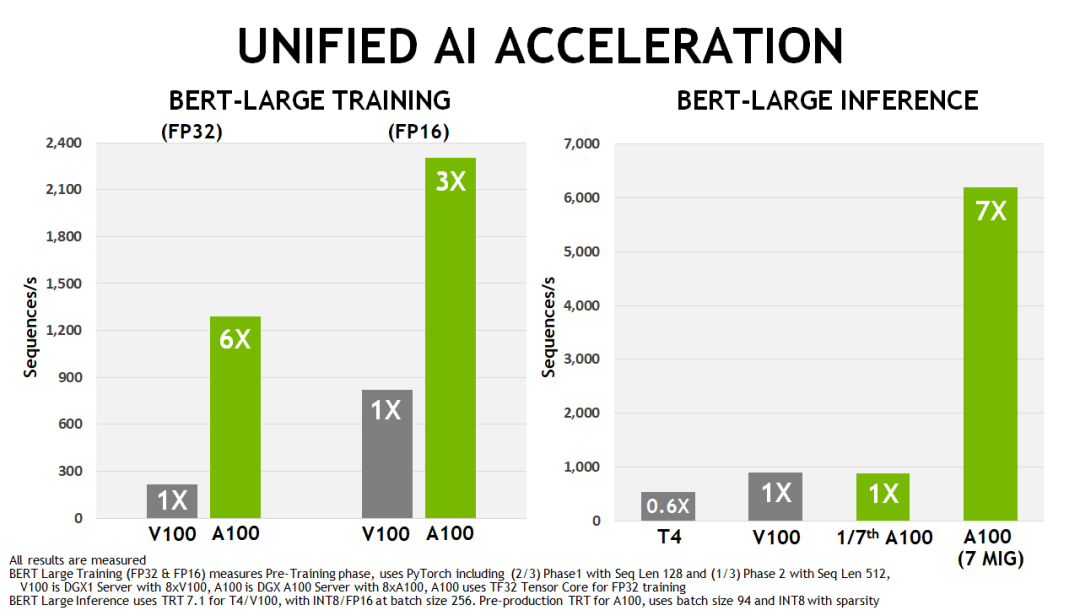

△相比Tesla V100和Tesla T4,A100 GPU在BERT训练和推理上的性能

还记得三年前推出、至今仍然业界领先的Volta架构芯片 Tesla V100吗?V100用300W功率提供了7.8TFLOPS的推断算力,有 210亿个晶体管,但A100的算力直接是前者的20倍。

全球最先进AI系统:

一个机架比肩整个AI数据中心

老黄亮出的第二个大招,是全球最先进的AI系统——NVIDIA第三代AI系统DGX A100系统,它被称之为“推进AI的终极工具”。

今天的人工智能任务包括模型的训练和推断,在原有人工智能系统 DGX-1 中,我们还在使用 GPU 负责训练、CPU 负责推断的分工方式。而有了 A100 芯片加持,第三代 DGX 可以把训练与推断全部交给 GPU 来完成,充分发挥先进架构的加速能力。

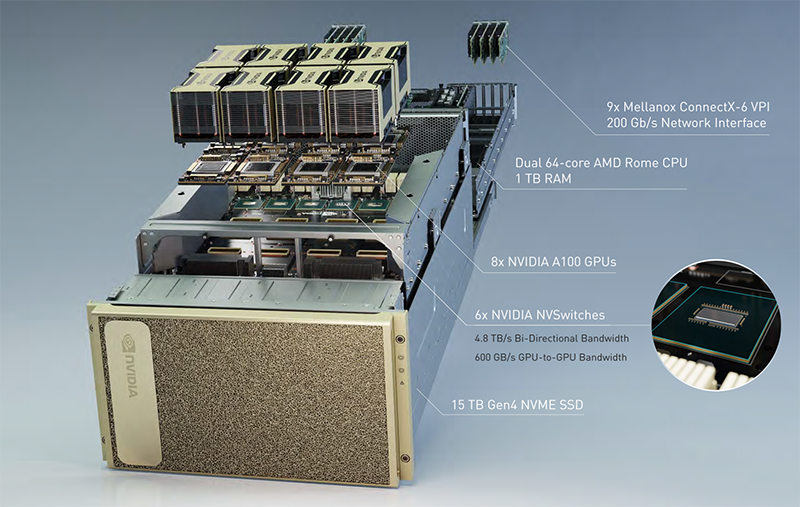

NVIDIA DGX A100系统将训练、推理、数据分析统一于一个平台,这是世界上第一台单节点AI算力达到5 PFLOPS的服务器, 每个DGX A100系统内部集成了8个NVIDIA A100 GPU和320GB内存。借助A100多实例GPU特性,每个系统可配置1到56个独立的GPU实例,从而交付灵活的、软件定义的数据中心基础设施。

现场老黄算了一笔账,一个典型的AI数据中心有50个DGX-1系统用于AI训练,600个CPU系统用于AI推理,需用25个机架,消耗630kW功率,成本逾1100万美元。这是什么概念呢?黄仁勋轻描淡写到,大约是一个州的价格!

而完成同样的工作,一个由5个DGX A100系统组成的机架,达到相同的性能要求,只用1个机架,消耗28kW功率,花费约100万美元。

「现在,你只需要十分之一的硬件成本,二十分之一电力消耗就能做同样的事。The more you buy, the more you save !(越买越省,买到即赚到)」黄仁勋说道。

DGX A100系统起价19.9万美元,已经开始在全球范围内交付,现可从NVIDIA及其已认证的合作伙伴处获取。

第一批DGX A100系统于本月早些时候交付给美国阿贡国家实验室(Argonne National Laboratory),用于加速COVID-19研究。

此外,多家全球大公司、服务提供商和政府机构已为DGX A100下了初始订单。

安培架构如此强大,英伟达这次也没有让数据中心以外的应用方向多等,直接放出了同样使用新架构的端侧芯片 Nvidia EGX A100,用于处理从物联网设备(无论是照相机还是智能冰箱)中的传感器输入的数据。

EGX A100每秒最多可以接收200GB的数据。新架构还允许在将芯片处理的来自IoT传感器的数据直接发送到GPU之前进行加密,从而使其更安全地应用于医疗保健或零售业。

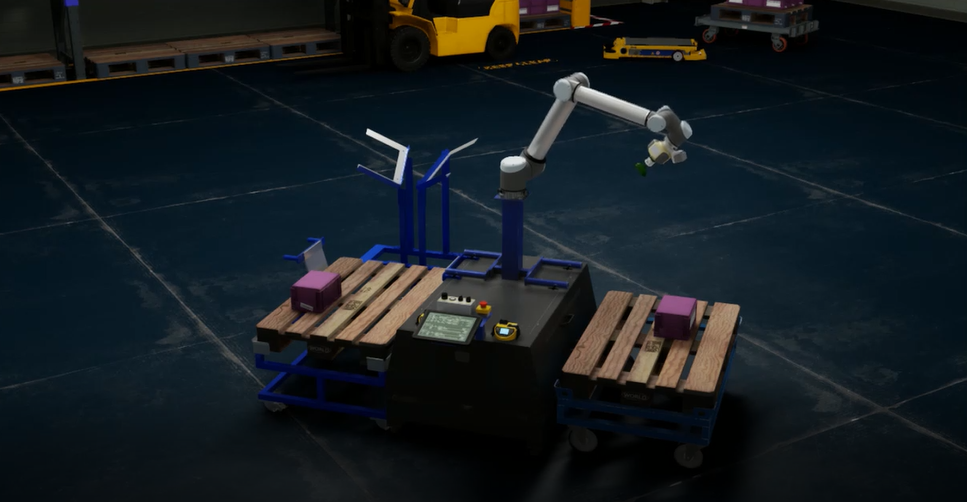

英伟达还介绍了旗下最新技术的一些应用案例,其中包括4月底刚刚发布的小鹏汽车P7,以及宝马集团采用英伟达解决方案全面提升工厂物流管理水平的例子。小鹏P7的XPILOT 3.0是国内首个搭载英伟达Xavier计算平台的自动驾驶量产方案,而且还搭载了两套。

在GTC媒体采访环节中,黄仁勋尤其强调了亚洲数据中心市场的重要性,“目前,亚洲是世界上对数据中心需求最大的地区。PC 革命、企业运算都发源于美国,美国也曾受益于企业运算,美国赶上了所谓的时机。而云计算和移动计算发源于亚洲,中国的云计算和移动计算是非常先进的。

例如中国有腾讯、阿里巴巴、美团、抖音等这些大型企业,上述不少中国公司正是中国算力基建中数据中心建设的主力军。亚洲不仅是我们公司特别重视的地区,更有许多我们重要的合作伙伴。我们希望能携手帮助中国的科技公司以及我们自身实现云计算的价值。”

宽泛科技作为英特尔、英伟达等芯片及品牌厂商的合作伙伴,NVIDIA潜力AI公司加速计划成员,携手专注为人工智能提供硬件解决方案及相关服务,已成为国内过万家企业、院校及研究机构的信息化解决方案供应商。

旗下Cloudhin®云轩支持Deep learning和高性能计算服务器定制,针对主要深度学习框架(如TensorFlow、Caffe 2、Theano或Torch)进行了优化和设置,在桌面上即可提供强大的深度学习功能。

WS4123深度学习工作站搭载第9代8核16线程Intel Core i9处理器,核芯迭代,动力强劲。双路Nvidia Tesla GPU,基于Volta架构,增加与深度学习高度相关的Tensor单元,单个GPU即可提供高达100个CPU的性能。强强联合,轻松应对如云计算、数据分析、后期制作、技术计算等多任务处理。

更多定制方案请联系客服,我们将实时响应您的定制需求,做您服务器的贴心管理者。